Stability AI 刚刚宣布推出 Stable Fast 3D(SF3D),这是一款新产品,可以在不到一秒的时间内从图像中生成带纹理的 UV 展开的 3D 资产。这是非常快速的,因为我之前尝试过的最后一个 AI 3D 生成器,如 Meta AI 的 3D Gen(文本到 3D)或清华大学的 Unique3D(图像到 3D),需要 50-60 秒来渲染 3D 资产。

在本文中,我们将看看这款新的 Stable Fast 3D 生成器是什么,它是如何工作的,以及您如何尝试它。

什么是 Stable Fast 3D?

Stable Fast 3D(SF3D)是一种新的方法,可以在短短 0.5 秒内从单个图像中快速生成高质量的带纹理的物体网格重建。

与大多数现有方法不同,SF3D 明确针对网格生成进行训练,并结合快速 UV 展开技术,实现了快速纹理生成,避免了对顶点颜色的依赖。该方法还预测材质参数和法线贴图,以增强重建的 3D 网格的视觉质量。

此外,SF3D 集成了去光步骤,有效消除低频照明效果,确保重建的网格可以轻松在各种照明条件下使用。

如果您想了解更多关于 Stable Fast 3D 的细节,请查看这里的白皮书 here。

工作原理

您可以通过上传一个物体的单个图像来开始。Stable Fast 3D 然后快速生成完整的 3D 资产,包括:

-

UV 展开的网格

-

材质参数

-

带有减少烘焙照明的颜色

-

可选的四边形或三角形重网格(仅在处理时间中添加 100-200 毫秒)

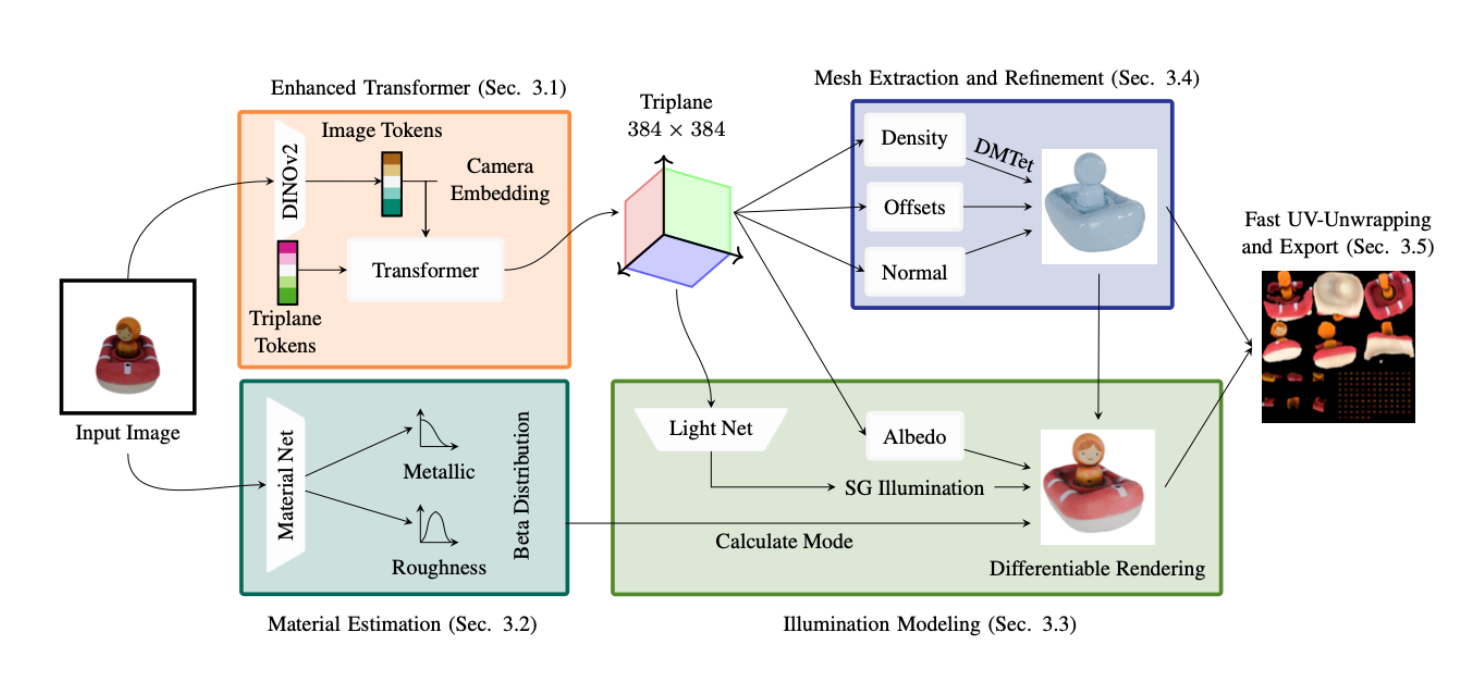

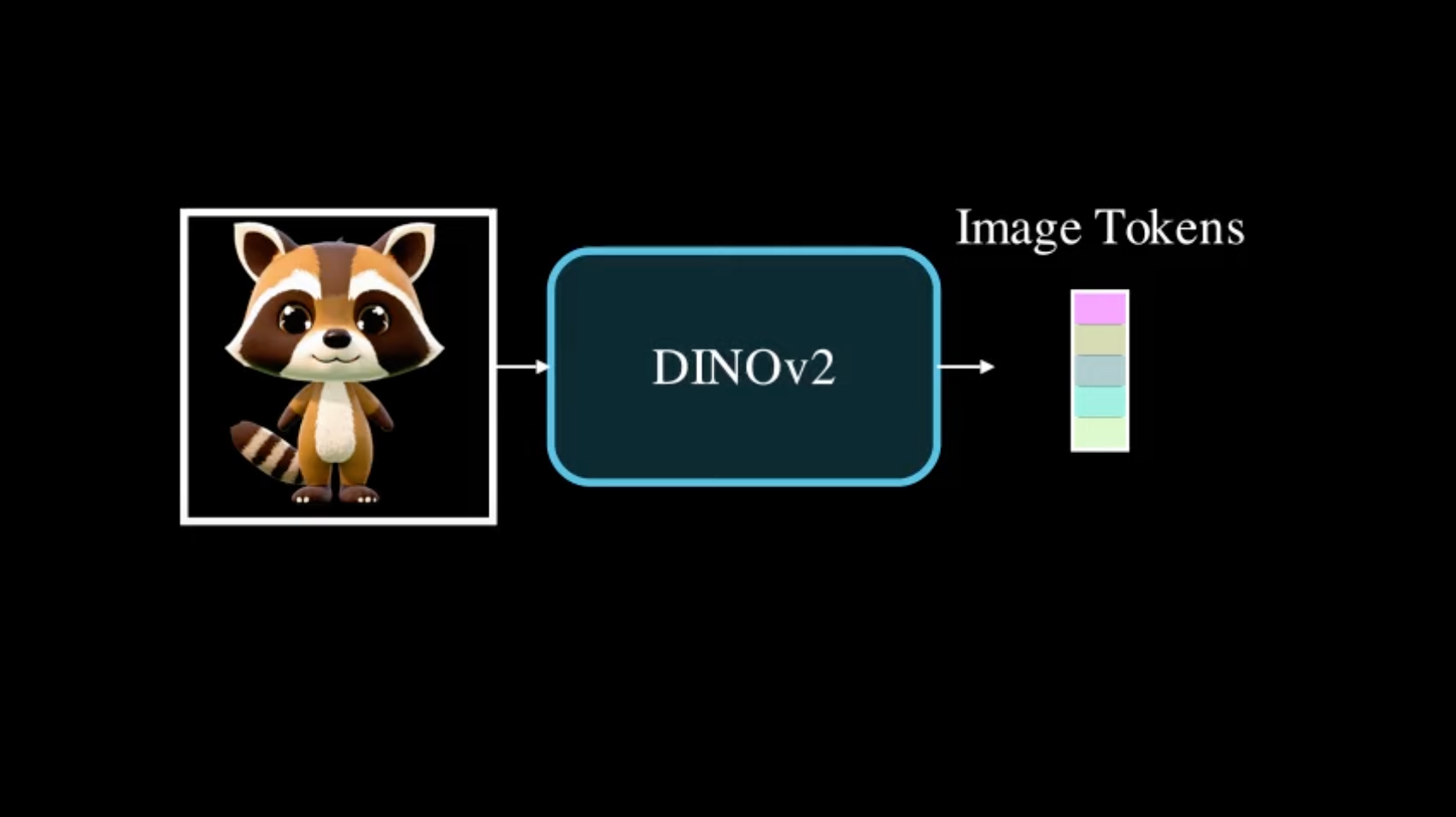

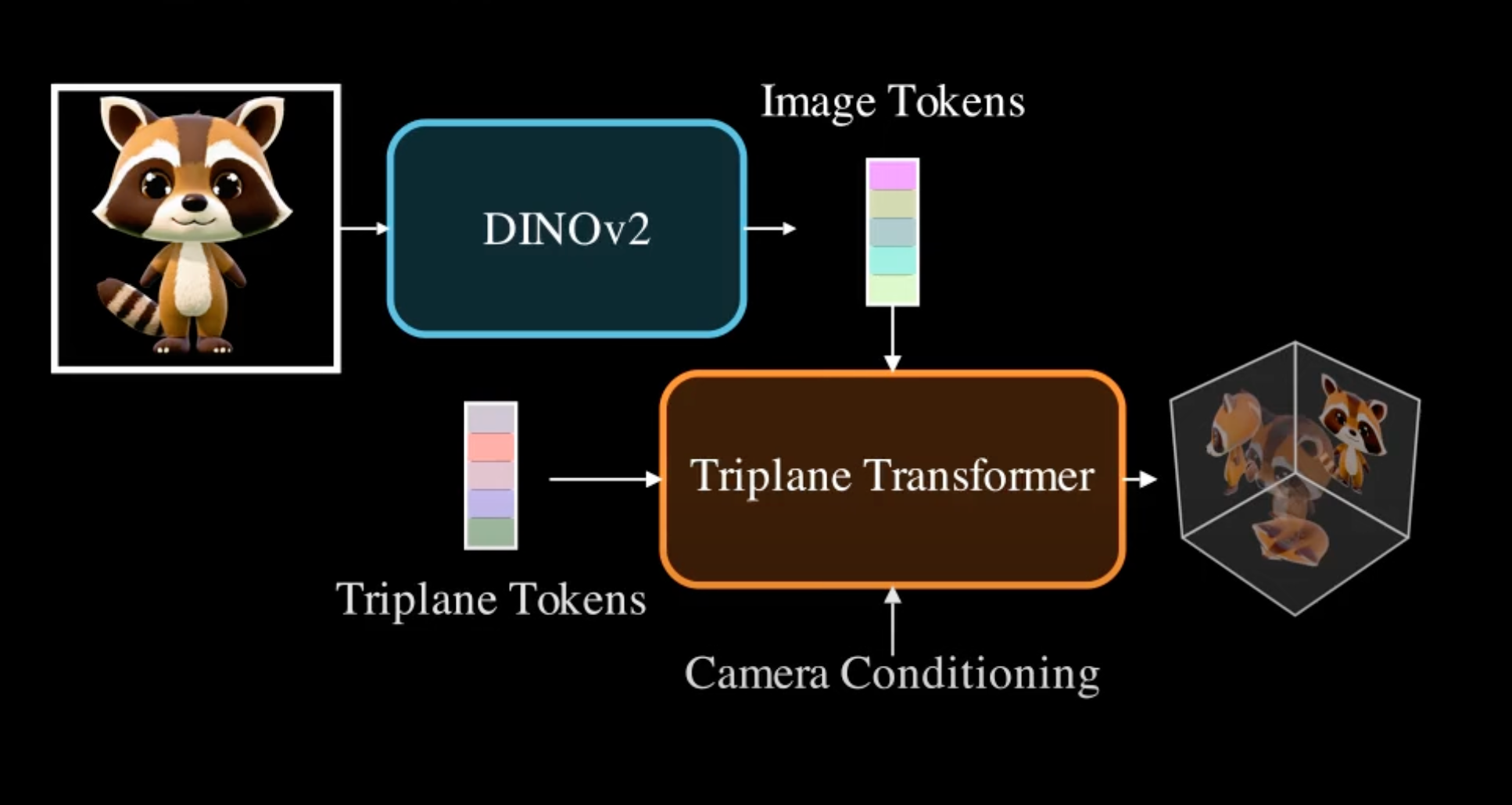

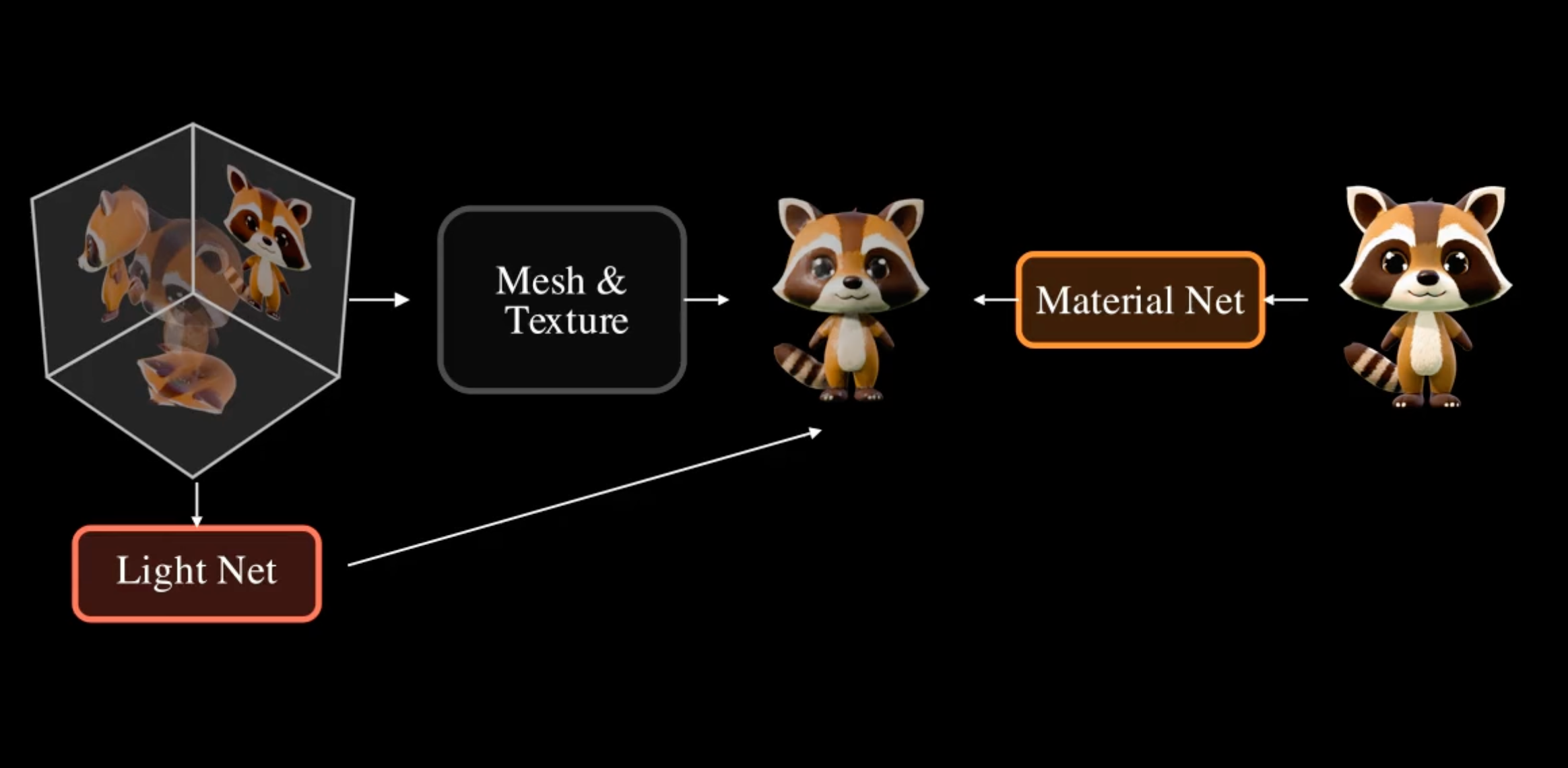

要使用 SF3D 生成 3D 物体,该过程从通过 DINO v2 编码器处理的输入图像开始,该编码器生成代表图像特征的图像 Token。

这些图像 Token 与相机 Token 一起输入到一个大型 Transformer 模型中,以预测编码场景的 3D 结构和外观的三平面体积表示。

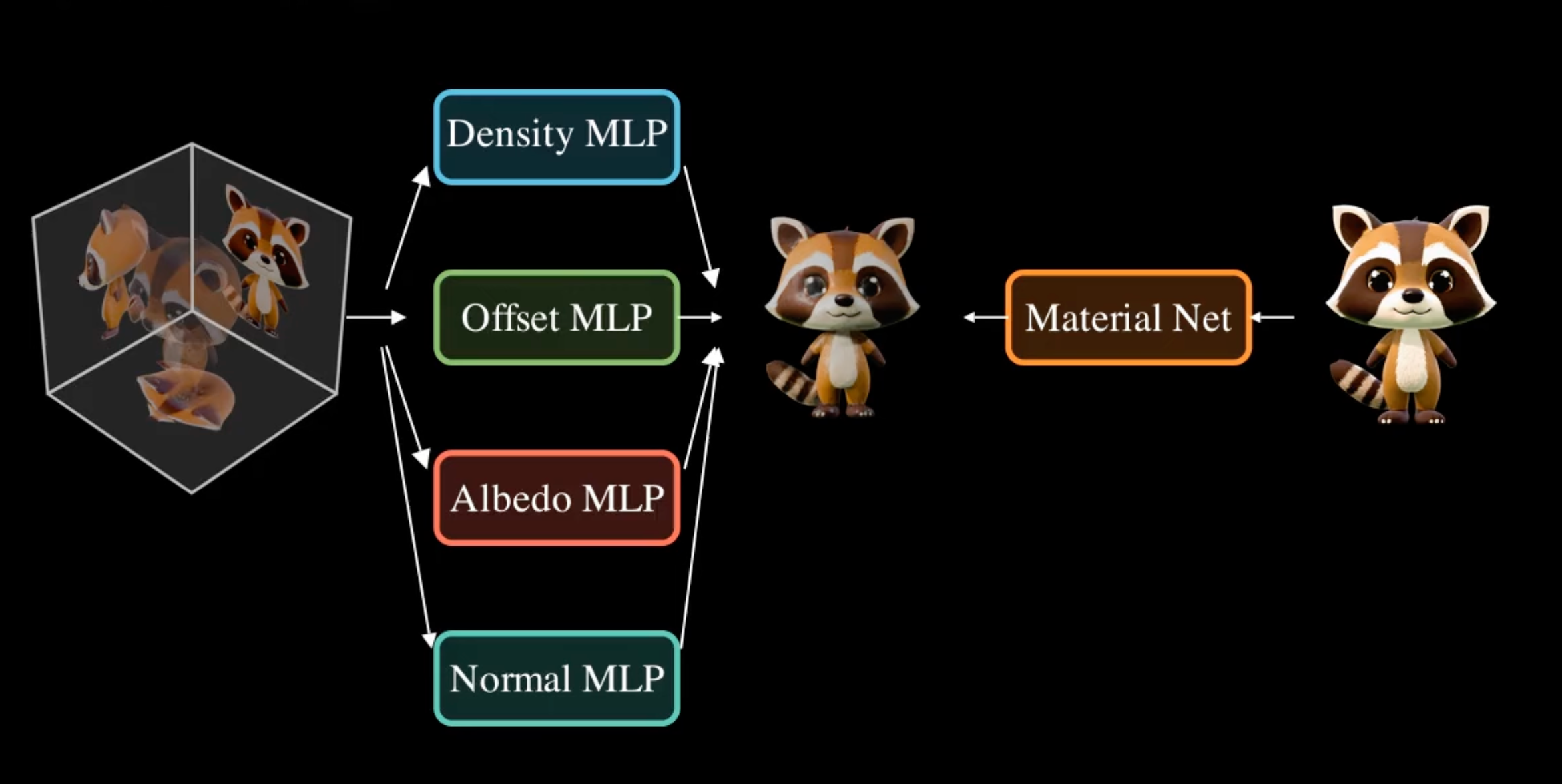

SF3D 不依赖于可微体积渲染,而是采用可微网格渲染器和网格表示。网格从预测的密度场中提取出来,并添加顶点偏移量,以产生更平滑和更准确的几何形状。

接下来,该方法提取固有颜色,即物体表面的内在颜色,不受照明影响,以及切线空间法线,提供表面细节和纹理。这确保表面看起来视觉上平滑和详细。另一个网络处理输入图像,以预测粗糙度和金属属性等材质参数,这对于逼真渲染至关重要,并为物体提供适当的反射特性。

在训练过程中,模型还预测场景的照明作为一组球面高斯函数,从三平面中提取,这些函数包含必要的 3D 信息。

最终图像是可微渲染的,结合了网格、固有颜色、切线空间法线和材质参数,以确保所有组件共同作用,产生高保真的 3D 资产。

用途

Stable Fast 3D 在游戏和电影制作中有多种应用。

-

在前期制作阶段利用其快速推理时间,这一阶段对广泛实验至关重要。

-

为游戏创建静态资产,如背景物体、杂物和家具。

-

为电子商务平台生成 3D 模型。

-

快速为 AR/VR 体验制作模型。

自己试一试

目前,有三种方式可以尝试 Stable Fast 3D。

-

该模型也可以通过 API 和 Stable Assistant 访问。

-

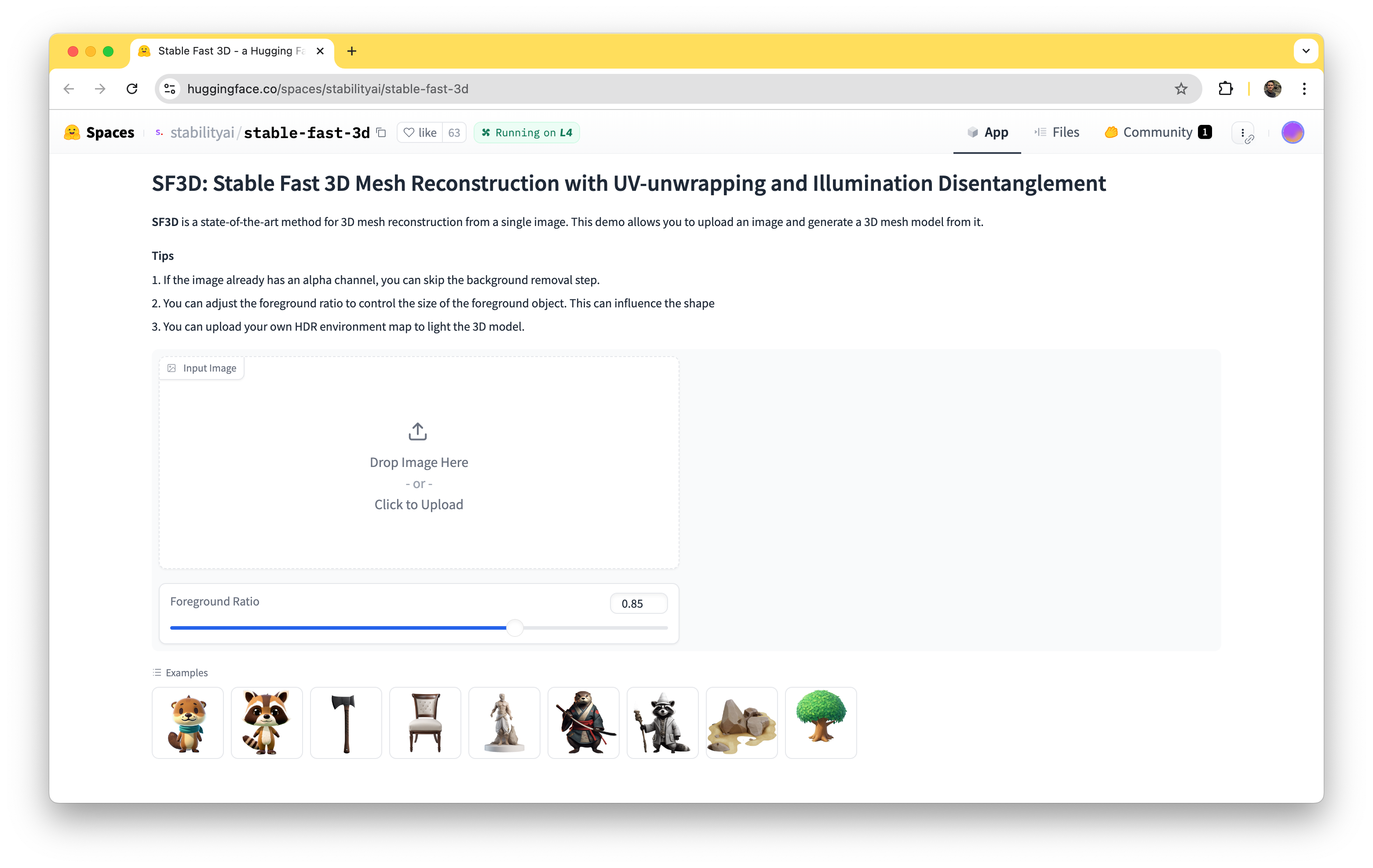

使用这个 HuggingFace 的 演示版本 来尝试。

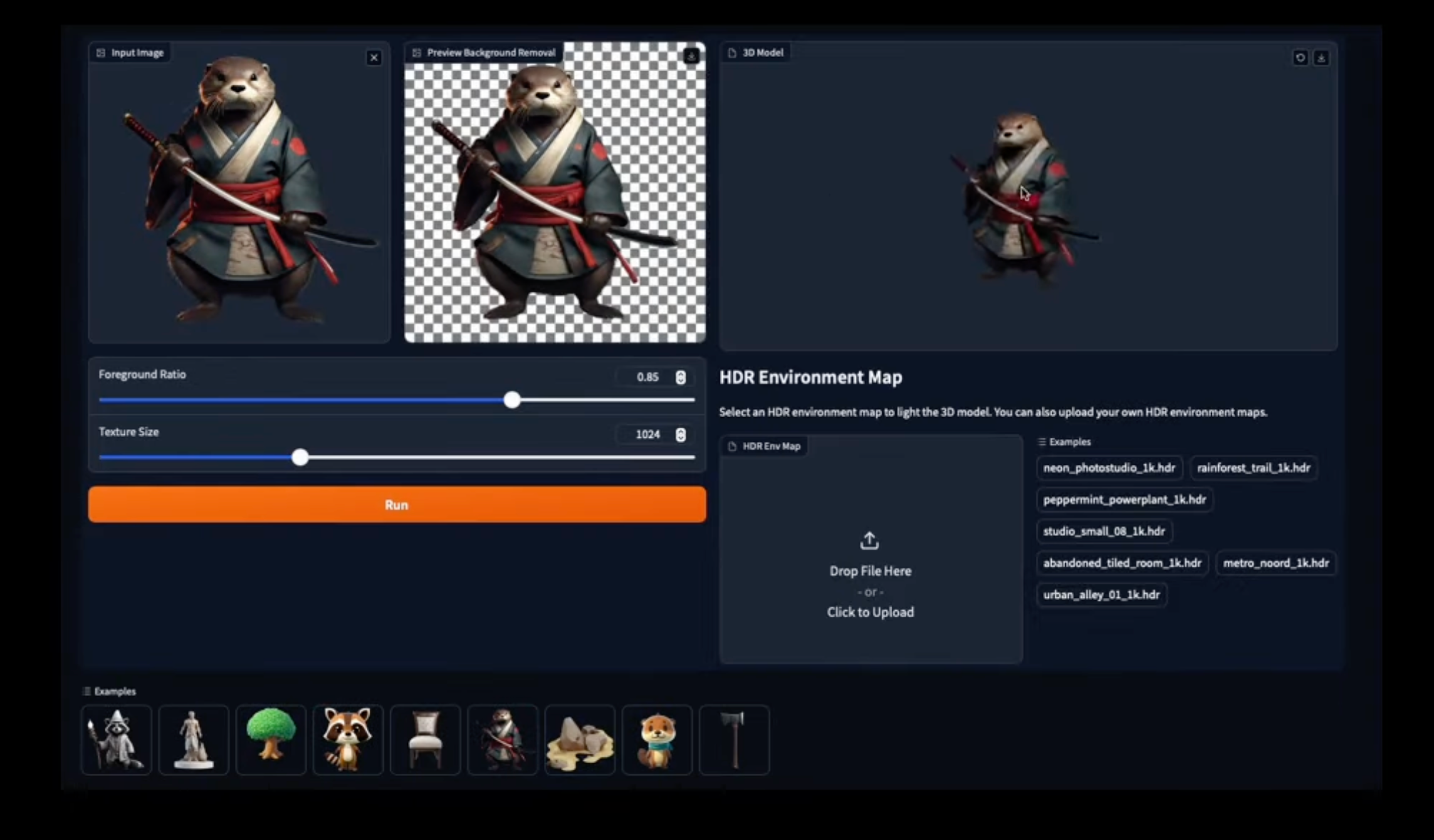

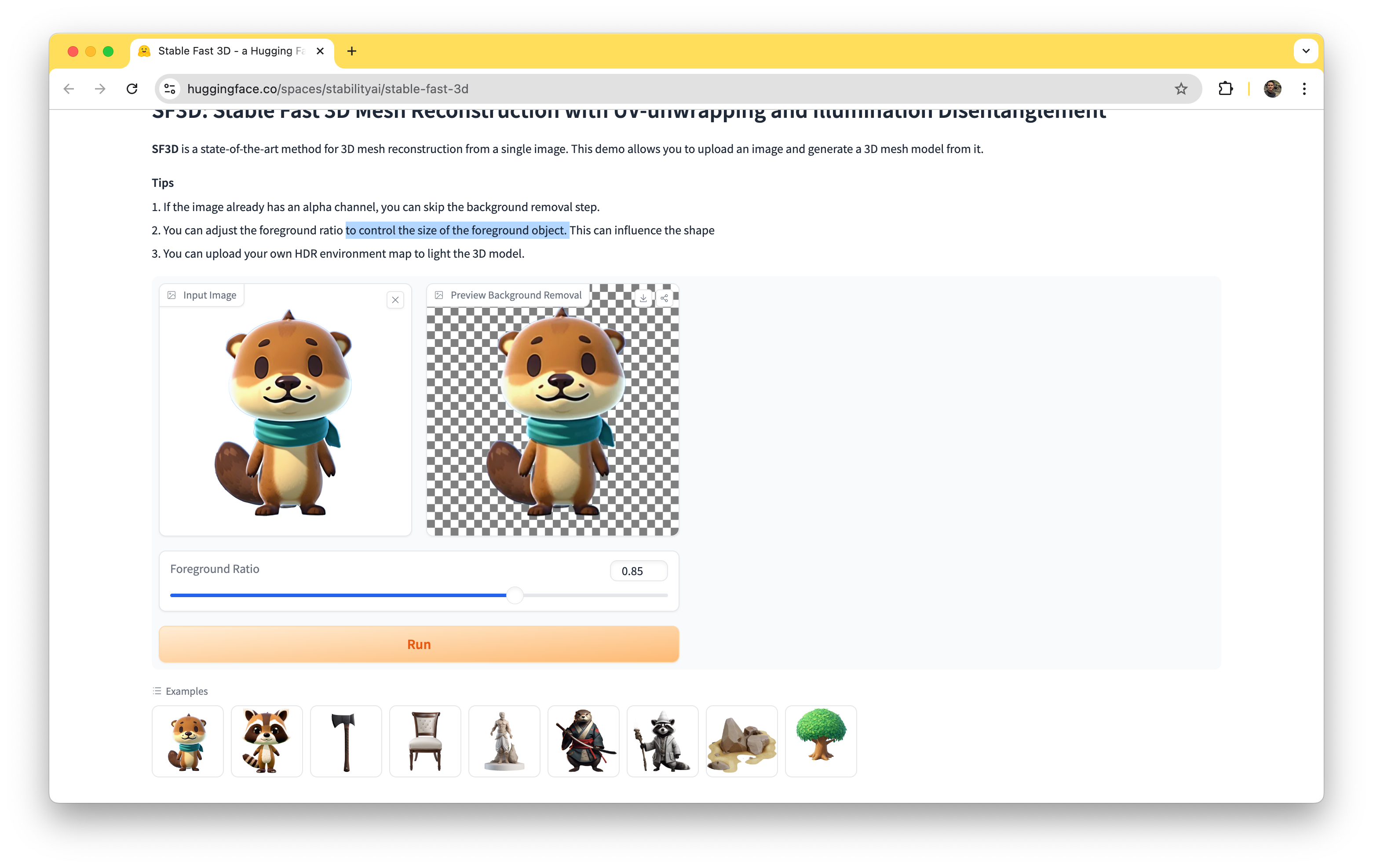

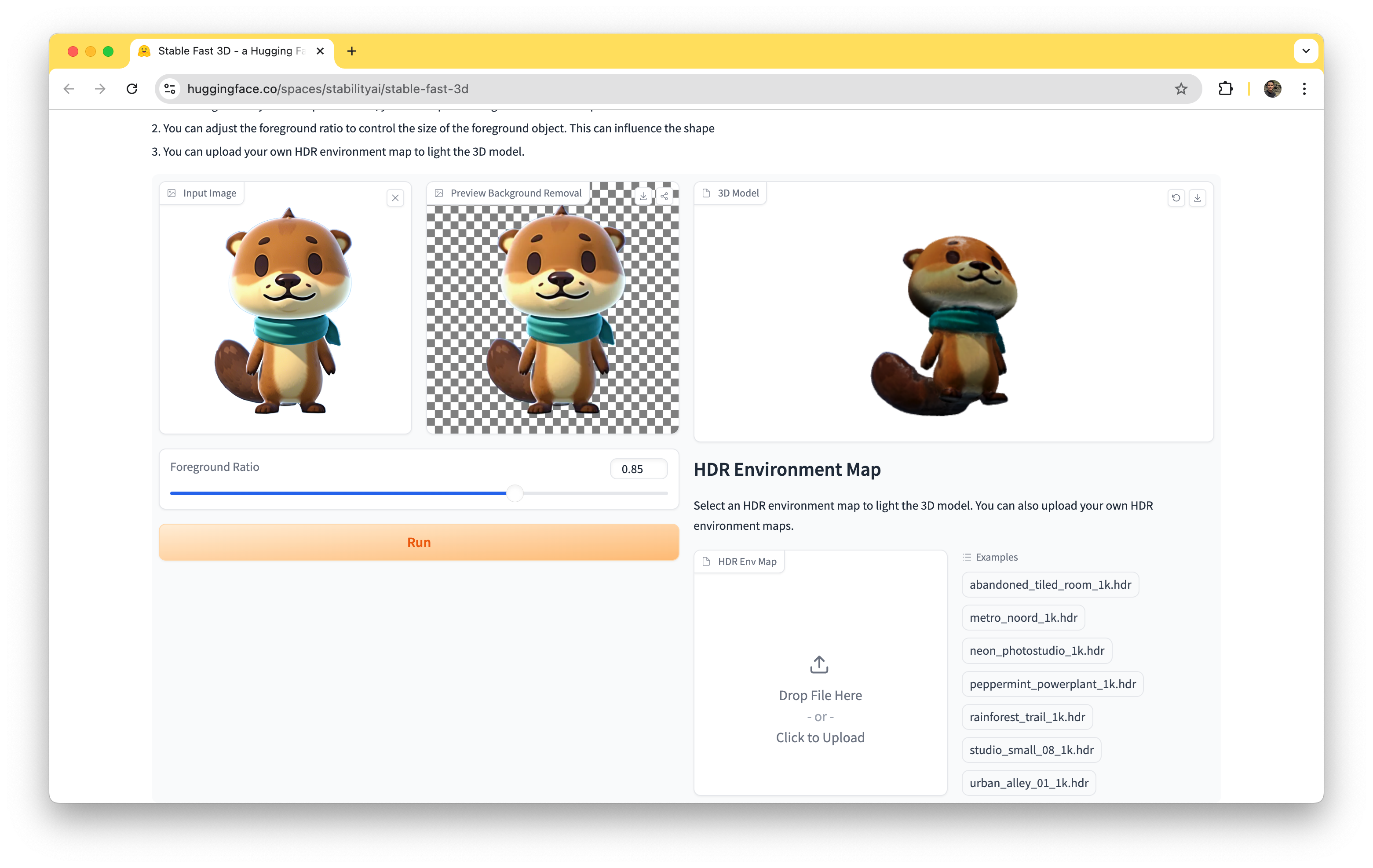

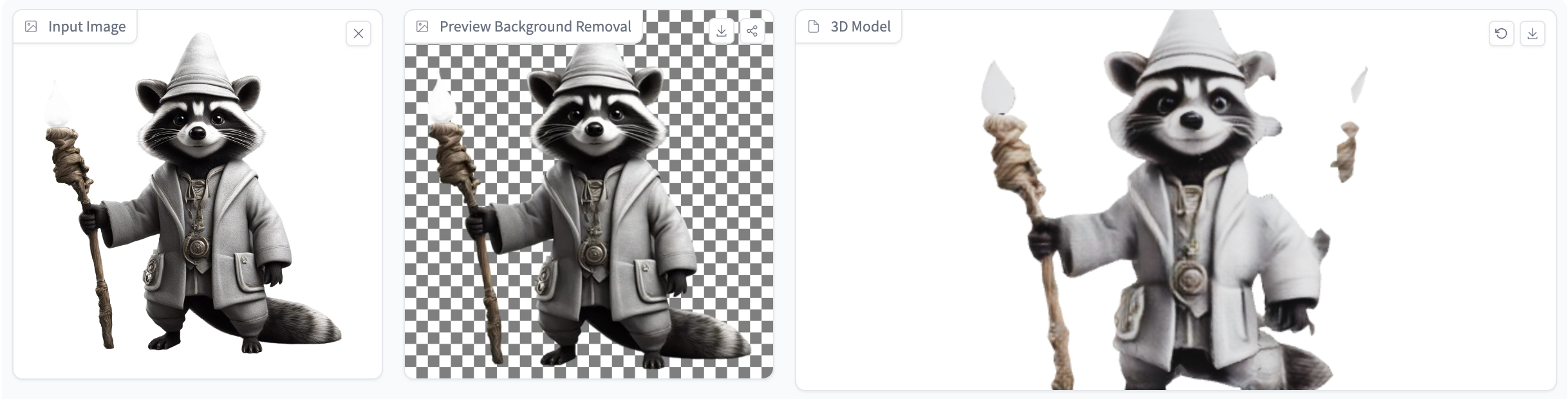

让我向您展示 HuggingFace 上的 Gradio 演示。只需将示例图像上传到下拉区域,并调整前景以控制前景对象的大小。

上传测试输入图像后,背景将自动移除。如果图像已经具有 alpha 通道,则可以跳过去除背景的步骤。点击“Run”按钮。

如其承诺的那样,处理时间非常快。仅经过几毫秒,结果将显示在仪表板的右侧部分。

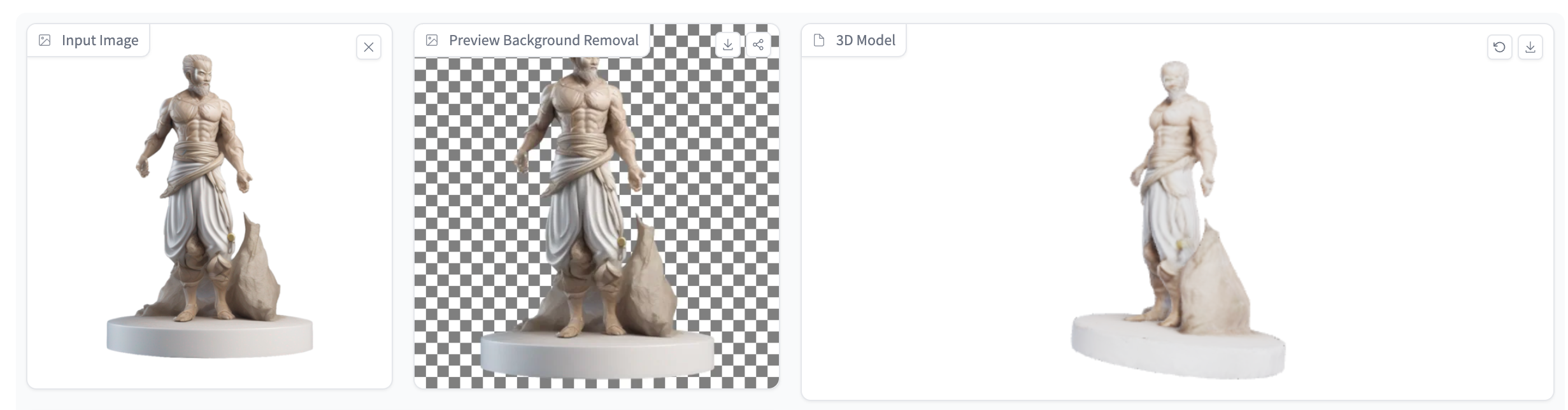

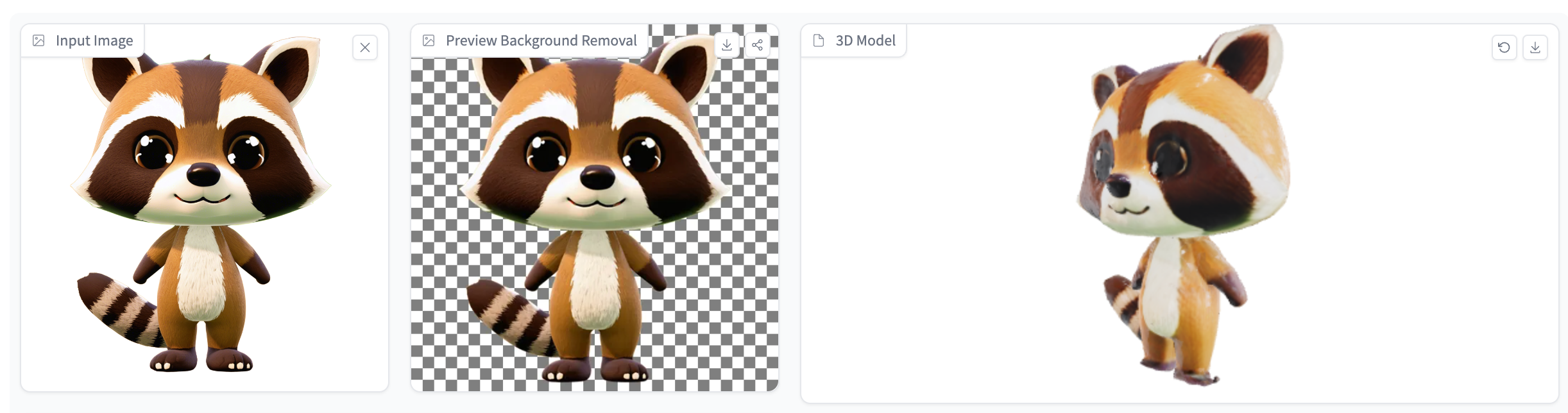

太棒了!结果是一个高质量的 3D 资产,您可以将其下载为 GLB 文件。这里有更多示例:

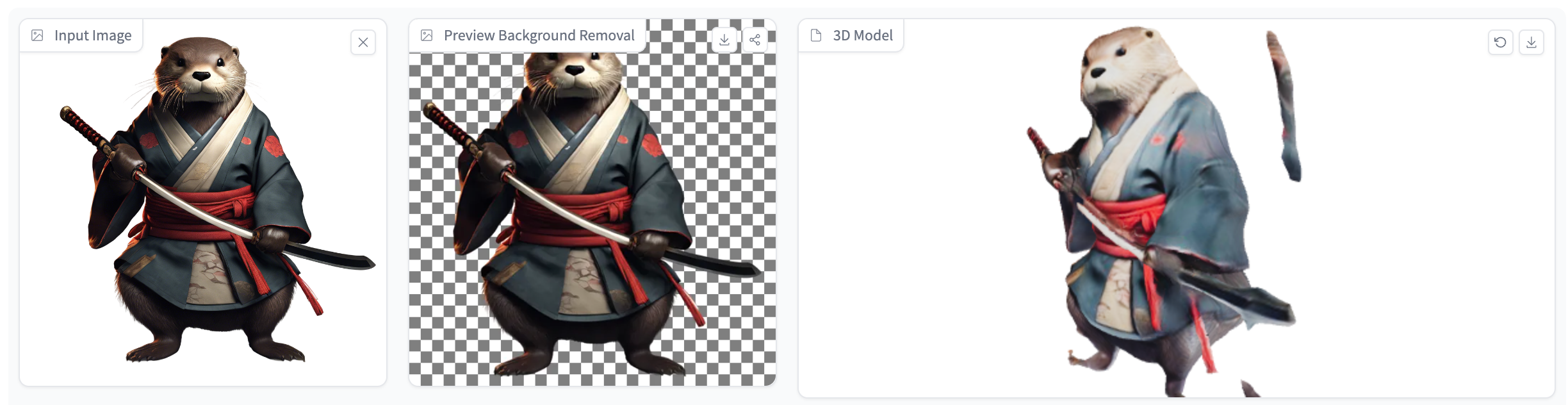

我注意到 AI 在渲染具有较小细节的对象时存在困难。看下面的例子:

在这种情况下,您可能需要降低前景比例值以解决问题。

请注意,Stable Fast 3D 是根据 Stability AI 的 社区许可协议 发布的,该协议允许非商业使用以及年收入不超过 100 万美元的个人或组织进行商业使用。

总结

总的来说,Stable Fast 3D 是一种新颖的 3D 资产生成方法。特别是在速度方面,我印象最深刻。就质量而言,尽管它可能已经足够处理基本形状的对象,但在处理具有复杂细节的复杂对象时仍然存在困难。

尽管公司最近面临的问题,特别是最近发布的 SD3 模型和内部管理问题,但我仍然很高兴看到他们宣布推出新的且相当不错的产品。