如果您和我年龄相仿,您可能还记得 Google 开始进入我们家庭使用的最初日子。我们的父母和祖父母对这项技术感到陌生,会像与人类交谈一样向它提问。

例如,“意大利总统是谁?”或者“明天的天气会怎样?”

随着年轻人对 Google 变得更加熟悉,我们不断告诉他们,“这是一台机器。您不必提出复杂的问题。只需写下一些简单的指令,比如‘意大利总统’或‘2028 年奥运会’。”

现在,情况已经发生了变化。在这个人工智能时代,我们用自然语言提出问题,以便机器更好地理解我们。

我们称这些结构化问题为“提示”。

因此,以下是十个改进日常提示的技巧,让您可以从大语言模型中获得想要的结果。

提示 1:包含专家的姓名

在您的提示中包含专家的姓名。通过这样做,大语言模型可以理解应该扮演什么专家角色以为您提供更好的回应。

例如,您想为新产品创建一个名称。在这种情况下,您将在提示中包含 Steve Jobs 的姓名(他是以引人注目的方式命名产品的专家)。

但请记住,这会生成特定于某个人风格的结果。或者,您也可以提及一些您喜欢的产品名称示例,而不是提及某人的姓名。

以下是一个额外的提示:如果您包含示例,请确保您使用两个井号将其与提示的其余部分分开。这就像 Markdown 的第二级标题。

示例提示: “给我五个我产品的潜在名称。

示例 Instagram、Facebook 和 Snapchat_”

我们这样做是为了让大语言模型更好地理解您的提示以及您提供的额外信息。这些信息可能是一些指示、一些背景信息,或者在这种情况下是示例。

提示 2:不要回避情感

在您的提示中包含情感。作为人类,我们是情感的存在,也会对情感做出回应。

大语言模型是根据我们多年来产生并在线上发布的数据进行训练的,因此它们对情感信息做出更好和更勤奋的回应并不奇怪。

在一个 YouTube 视频中,用户要求大语言模型创建一些高尔夫球技巧。他在大写字母中添加了另一句话,“高尔夫对我的职业非常重要。” 这句话向大语言模型传达了一种紧迫感,并要求它做出更加勤奋的工作。

示例提示: “给我五个最容易掌握的高尔夫球技巧。高尔夫对我的职业非常重要。”

提示 3:指定格式

给出您希望回答的格式示例。

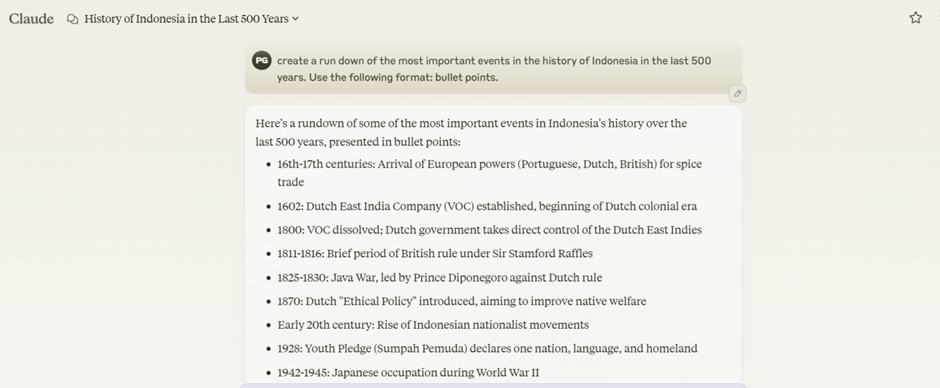

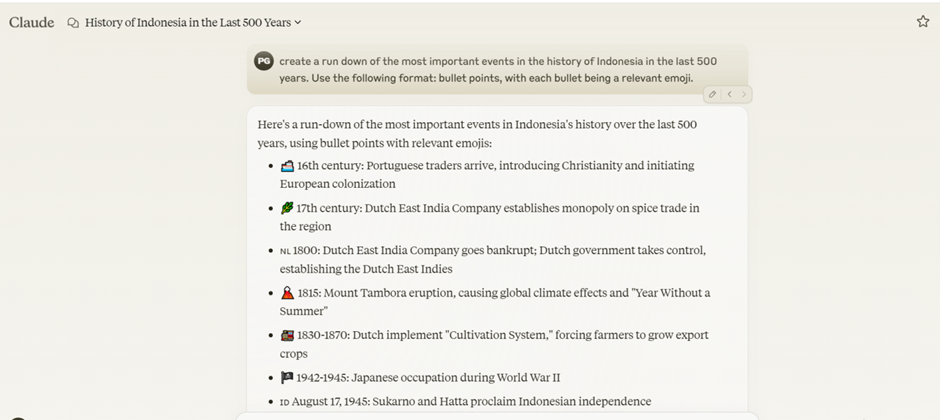

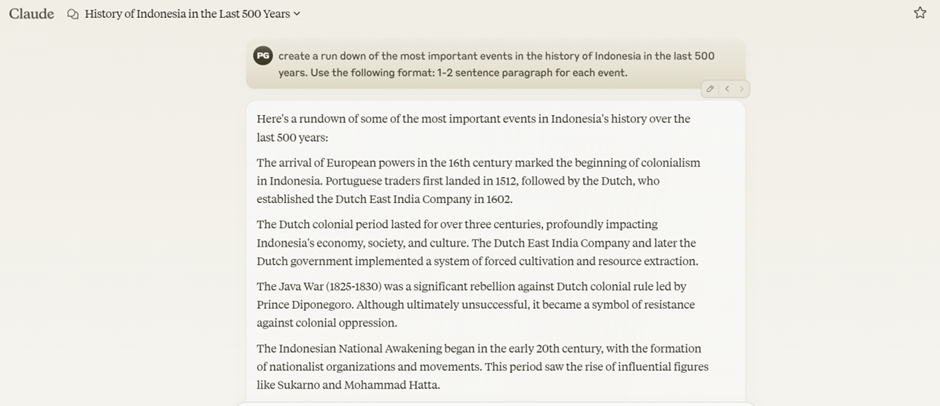

让我们看一个 Claude 的例子。

我要求 Claude 创建过去 500 年里巴西历史上最重要事件的总结。

我要求它使用特定格式。例如,我使用了以下格式:项目符号,结果以项目符号格式创建。

接下来,我希望每个项目符号都是相关的表情符号。它是否在每个项目符号旁边创建了一个表情符号?看一看。

另一个例子是每个事件一个到两个句子的段落。

通过在您的回应中包含特定格式,您可以节省时间。

提示 4:告诉大语言模型扮演专家角色

告诉大语言模型认为自己具有某种专业知识。

示例提示: 您是一名天体物理学家。解释黑洞在宇宙中扮演的角色。

示例提示: 什么是厨房中掌握的三个最重要的技能?像一名米其林星级厨师一样回答。

您可能认为告诉大语言模型假装成专家是微不足道的,因为它们本身就是专家。然而,这为大语言模型提供了宝贵的上下文,以理解如何向您呈现数据。

而且不一定要是特定的角色。您也可以要求大语言模型以某种方式行事。

示例提示: 您是一位乐于助人的讲师,逐步解释概念而不显得居高临下。您只包含相关信息,并避免过多细节。解释黑洞在宇宙中扮演的角色。

只需记住,为了获得完美的表现,请保持这些指示简洁。

提示 5:引导思维链提示

您希望以一种方式向大语言模型提问,而不是简单地给出短暂回答,而是逐步解释。这种提示方式称为引导思维链提示。这样,您可以跟踪大语言模型是如何得出结论的,并进行事实核查以确保其正确性。

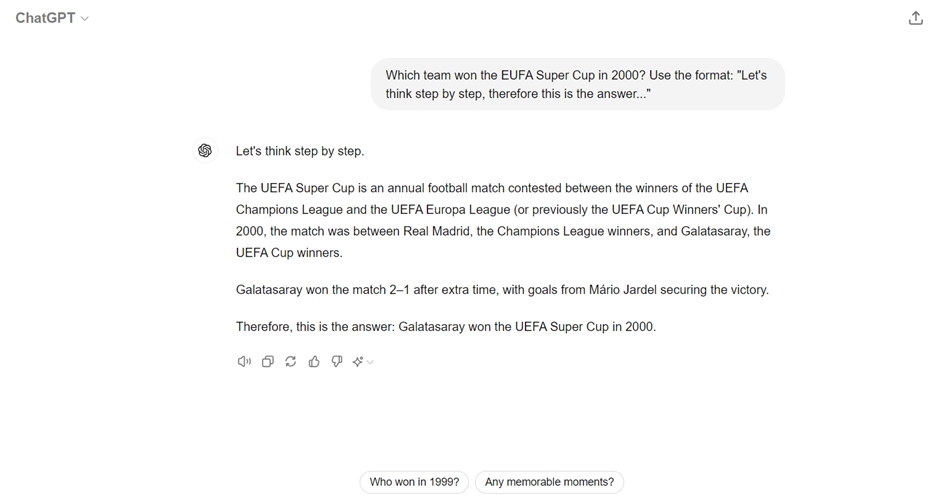

让我们在 ChatGPT 上看一个例子。我问 ChatGPT:“2000 年欧洲超级杯的冠军是哪支球队?”

然后,我要求它使用以下格式:“让我们逐步思考。因此,这就是答案。”

在这里,它是逐步思考的。

它说欧洲超级杯是由两个主要欧洲俱乐部比赛的卫冕冠军争夺的年度足球比赛。正如您所看到的,回应是详细的。

它告诉我欧洲超级杯是什么时候举办的,谁有资格参加,谁赢了,而且是加拉塔萨雷,这是正确的。

提示 6:使用提示链接

与其一次性获得最终输出,不如使用提示链接。提示链接将您的任务分解为子任务,并要求大语言模型分别完成它们。

例如,如果您想构建一个 Web 应用程序,您可以向大语言模型询问或向其解释您的想法。在构思后,要求它为应用程序创建架构。

此外,您可以要求它为前端提供代码,然后为后端提供代码。

这样,您可以跟踪每个步骤中发生的情况,并防止错误破坏整个项目。

提示 7:总结长对话

偶尔总结您的长时间、信息密集的对话。

要求大语言模型总结您迄今为止的对话。复制总结的文本,粘贴到新的讨论中,并就此提出新问题。

这样,您可以避免大语言模型陷入您之前讨论的不相关细节中。因此,这种策略确保它只处理最重要的信息。

提示 8:使用在线工具

我发现的一个有用工具是 Anthropic 的提示库。

对于您可能想要使用大语言模型实现的许多任务来说,这是一个很好的起点。

提示 9:要求大语言模型自我纠正

这个提示有点奇怪,但如果您担心正确性,请要求 AI 自我纠正。

有时,大语言模型会创建事实不准确的回应,或者它们说的一些内容可能有错误的假设。

快速检查这一点的一种方法是将您从一个大语言模型获得的回应复制粘贴到另一个大语言模型。您也可以打开一个单独的对话,但询问另一个大语言模型更有效。您可以写,“这里有任何事实错误吗?”

或者,您甚至可以要求大语言模型告诉您在文本或您创建的任何内容中它不同意的地方。

这种情况就像一箭双雕,因为您可以检查您生成的内容的正确性,并对同一主题有一个细致入微的看法。

提示 10:自动化您的提示

许多事情的命运都是如此,即使提示也可以自动化。

如果您正在处理一个用例,您宁愿有最佳提示,请使用在线提示工具以获得最佳和最优化的提示。

您可以使用的一些工具包括 Chatbot Arena 和 Prompts Royale。还有许多其他工具。通过快速搜索,您可以找到最适合您情景的最佳工具。您也可以要求大语言模型推荐一个。

额外提示:使用大语言模型生成您的提示

当我第一次尝试使用大语言模型生成我的提示时,我感到惊讶。但是现在当您考虑到这一点时,这就有了很多意义。

由于大语言模型不断接受再训练,它们将了解什么构成一个好的提示和不那么好的提示。成千上万的提示工具可能每月收取 20 到 30 美元来创建提示。

然而,如果您使用大语言模型本身来生成提示,您可以节省金钱。不仅如此,您还可以获得更好的提示。作为额外好处,您将更好地了解大语言模型及其回应。不妨试一试,看看是否适合您。